Le Grand collisionneur de hadrons (LHC) du CERN vient de connaître une avancée majeure et prometteuse grâce à l’intelligence artificielle. La collaboration CMS a démontré pour la première fois que l’apprentissage automatique peut reconstruire intégralement les collisions de particules, le faisant avec une vitesse et une précision inégalées par les méthodes traditionnelles. Cette prouesse technologique ouvre des perspectives fascinantes pour la physique des particules, notamment avec l’arrivée du LHC à Haute Luminosité.

Un Défi de Taille : Comprendre l’Infini Petit

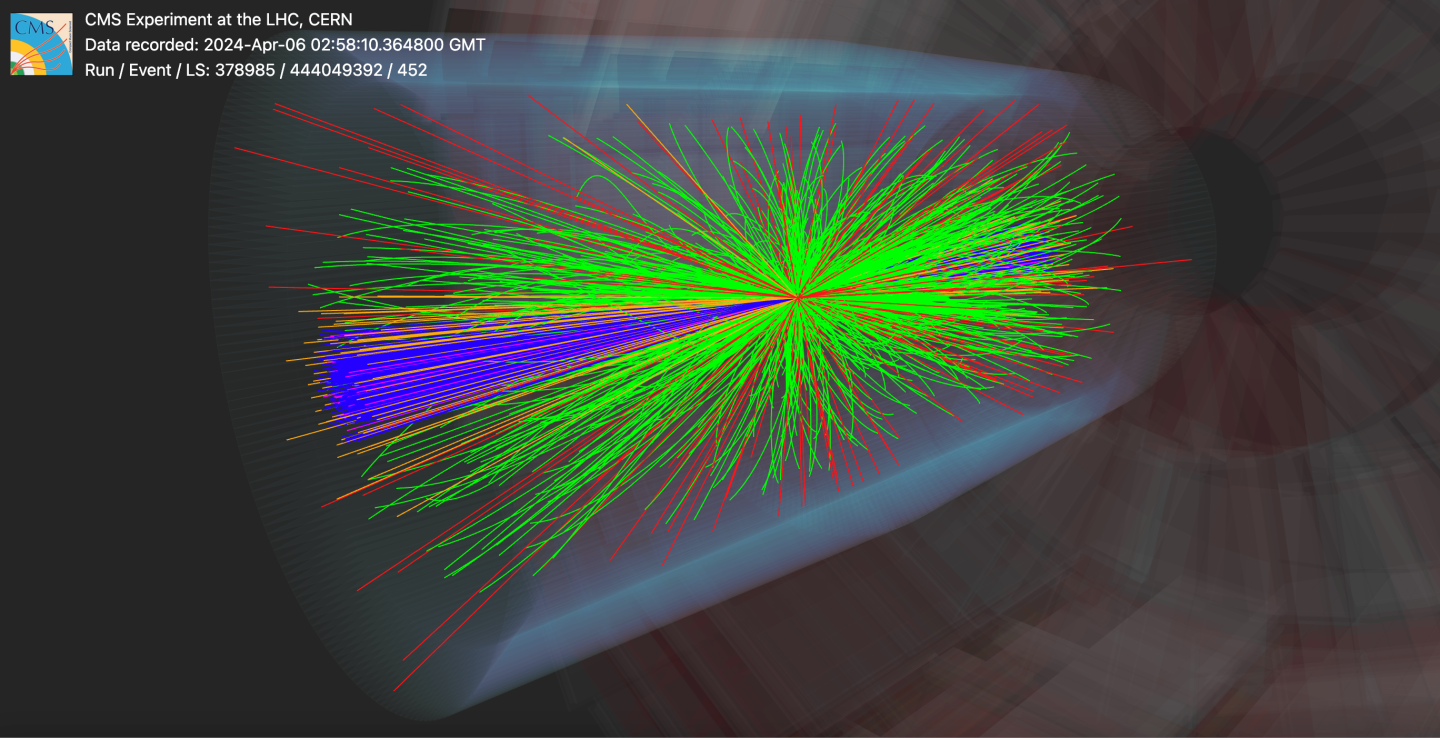

Depuis plus d’une décennie, le Grand collisionneur de hadrons (LHC), situé à la frontière franco-suisse, est le plus puissant accélérateur de particules au monde. Son objectif est de sonder les lois fondamentales de l’univers en faisant entrer en collision des protons à des vitesses proches de celle de la lumière. Chaque collision, d’une violence inouïe, génère une multitude de particules éphémères formant des motifs complexes. Les physiciens des expériences comme CMS (Compact Muon Solenoid) doivent ensuite « reconstruire » ces événements pour comprendre ce qui s’est réellement passé, déceler de nouvelles particules ou tester les limites du Modèle Standard, notre meilleure théorie pour décrire l’univers. Traditionnellement, cette tâche reposait sur des algorithmes dits « à flux de particules » (PF), combinant minutieusement les informations des différents détecteurs. Si cette méthode a donné d’excellents résultats, elle s’appuyait sur une longue chaîne de règles définies manuellement par des équipes de physiciens, un processus rigide et chronophage.

L’Apprentissage Automatique Révolutionne la Reconstruction

C’est ici qu’intervient l’apprentissage automatique, ou machine learning, et plus précisément le nouvel algorithme MLPF (Machine Learning-based Particle-Flow) de la collaboration CMS. Plutôt que d’être programmé avec des règles explicites sur la manière de reconstruire les particules, cet algorithme apprend directement à partir de simulations de collisions. Comme un humain apprend à reconnaître des visages sans mémoriser chaque trait un par un, le MLPF assimile l’apparence des particules dans les détecteurs. Cette approche fondamentale transforme la logique rigide en un modèle unique et adaptatif, capable de déchiffrer les schémas complexes des données expérimentales avec une efficacité inédite. L’analogie avec la reconnaissance faciale est particulièrement éclairante, car elle souligne la capacité de l’IA à identifier des motifs subtils et des corrélations complexes qui échapperaient à une programmation manuelle.

Précision et Rapidité : Les GPUs changent la donne

Les premiers tests de l’algorithme MLPF, effectués sur des données mimant celles de l’actuelle phase d’exploitation du LHC, ont été spectaculaires. Non seulement ses performances ont égalé celles des algorithmes traditionnels, mais dans certains cas, elles les ont surpassées. Par exemple, lors de l’analyse d’événements simulés impliquant la création de quarks top, l’algorithme a amélioré la précision de la reconstruction des gerbes de particules (appelées « jets ») de 10 à 20 % dans des gammes clés d’impulsion. Mais l’un des atouts majeurs de cette nouvelle méthode réside dans sa rapidité d’exécution. Grâce à sa capacité à fonctionner efficacement sur des processeurs graphiques (GPU), le MLPF reconstruit une collision bien plus vite qu’auparavant. Les algorithmes traditionnels, dépendants des processeurs centraux (CPU), sont souvent moins performants que les GPUs pour ce type de tâches de calcul parallèle intensif, un avantage crucial lorsque l’on traite des volumes massifs de données.

Vers le LHC à Haute Luminosité : Une Nécessité Impérieuse

L’impact de cette innovation sera d’autant plus grand avec l’arrivée du LHC à Haute Luminosité (HL-LHC), dont le démarrage est prévu pour 2030. Cette mise à niveau promet de multiplier par environ cinq le nombre de collisions de particules, générant une quantité de données colossale qui mettra à rude épreuve les capacités de traitement des expériences du LHC. « Les nouvelles applications de l’apprentissage automatique pourraient rendre la reconstruction des données plus précise et bénéficier directement aux mesures de CMS, des tests de précision du Modèle Standard aux recherches de nouvelles particules, » déclare Joosep Pata, développeur principal de l’algorithme MLPF. « Notre objectif ultime est de tirer le maximum d’informations des données expérimentales de la manière la plus efficace possible. » En enseignant aux détecteurs à apprendre directement des données, les physiciens ne se contentent pas d’améliorer les performances ; ils redéfinissent les frontières de ce qui est possible en physique des particules expérimentale, préparant le terrain pour des découvertes potentiellement révolutionnaires.

Perspectives et Implications Futures : Un Nouveau Paradigme

Au-delà des murs du CERN, les avancées en intelligence artificielle pour la physique des particules ouvrent des perspectives pour d’autres domaines scientifiques et industriels. Les méthodes de traitement de données massives, la détection de motifs complexes et l’optimisation des calculs développées pour le LHC pourraient inspirer des applications en imagerie médicale, en modélisation climatique, en conception de nouveaux matériaux ou même en analyse financière. L’expertise française et européenne, déjà à la pointe dans le domaine de l’IA et de la physique fondamentale, se trouve renforcée par ces innovations. Cette convergence de la physique et de l’intelligence artificielle promet non seulement de percer de nouveaux secrets de l’univers, mais aussi de stimuler des percées technologiques qui bénéficieront à la société dans son ensemble, façonnant le futur de la recherche et de l’innovation.

Mots-clés : apprentissage automatique, LHC, CERN, physique des particules, intelligence artificielle

Source : Article original